|

| Traducción del ARN en los ribosomas para sintetizar proteínas. (imagen CC LadyofHats traducida por Parri, vía Wikimedia Commons) |

Un buen ejemplo de la presencia de estas moléculas orgánicas (es decir, basadas en el carbono) son las varias formas del colágeno, que forma el 35% de todas las proteínas que nos componen. El colágeno es esencial en estructuras tales como los ligamentos y tendones, de la piel, los vasos sanguíneos y la córnea, y está en los huesos, el sistema digestivo, los músculos… y en en la superficie de las células. De todas nuestras células.

Hay muchos tipos de proteínas, como la queratina que forma nuestro cabello y uñas, la miosina y la actina, responsables de la contracción de nuestros músculos, la albúmina que forma gran parte de nuestro plasma sanguíneo (pariente de la albúmina de las claras de huevo), los ácidos nucleicos (el ADN y el ARN), todas las enzimas que promueven multitud de reacciones químicas en nuestras células, y todas, todas nuestras hormonas, desde la insulina que nos ayuda a metabolizar el azúcar hasta los neurotransmisores y las hormonas sexuales.

Estas son proteínas muy abundantes en nuestro cuerpo, pero hay muchas más. En total, se calcula que nuestro cuerpo tiene al menos dos millones de proteínas que actúan como reguladoras, para defenderlo (anticuerpos), transportar oxígeno (hemoglobina) y de muchas otras formas.

Asombrosamente, estos millones de proteínas, y las al menos diez millones más que son parte de los demás seres vivos (que comparten algunas) son producidas con sólo 20 aminoácidos principales como materia prima.

¿Cómo es esto posible? Pensemos en la escala musical que conocemos: tiene 12 notas, pero las escalas tradicionales usan sólo siete de esas notas, aunque las armonías modernas pueden usar más.

Con sólo doce notas, la capacidad humana ha creado literalmente millones de variaciones, desde la música más chabacana y sencilla hasta las más complejas creaciones de Bach, desde las tonadillas publicitarias hasta las obras conceptuales de Pink Floyd, de las nanas al heavy metal. La enorme variedad de la música nos permite olvidar fácilmente que, pese a todo, son sólo doce notas.

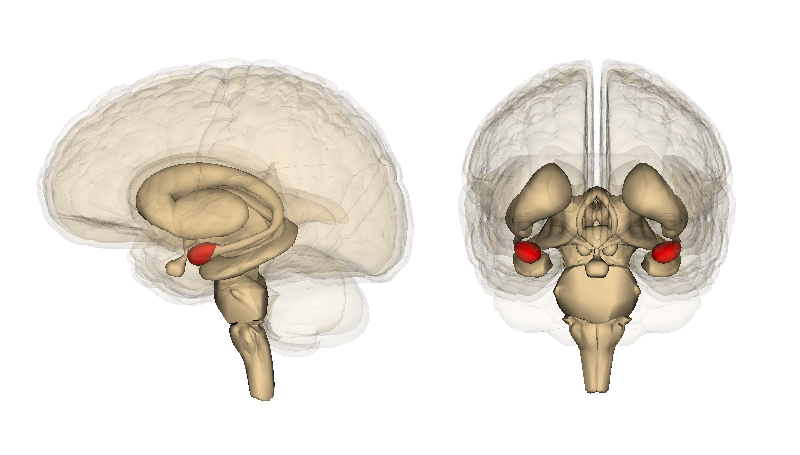

Los más o menos 25.000 genes capaces de crear proteínas que tenemos en los núcleos de nuestras células pueden sintetizar esa millonaria variedad formando largas cadenas de aminoácidos unidos entre sí. Para producir una proteína, el ADN del núcleo forma primero una cadena de ARN mensajero a la que le traslada su código químico para llevarlo fuera del núcleo. El lenguaje del ARN tiene cuatro letras únicamente, AGCU o adenina, guanina, citosina y uracilo. Cada grupo de tres bases o letras del ARN se llama “codón” porque codifica la captura de un aminoácido determinado. La secuencia de codones se traduce en la secuencia de aminoácidos de la proteína.

Como hay 64 palabras posibles combinando en grupos de tres las cuatro letras del lenguaje del ARN, hay “palabras” redundantes. Por ejemplo, los codones o palabras “UAU” y “UAC” corresponden al aminoácido llamado tirosina, mientras que otros aminoácidos como la arginina pueden ser codificados con hasta seis codones. Así, se van “escribiendo” o sintetizando proteínas que pueden ser cadenas de menos de 10 aminoácidos o llegar a tener más de 100.

En palabras de uno de los descubridores del ADN, Sir Francis Crick, “el ADN hace ARN, el ARN hace proteínas… y las proteínas nos hacen a nosotros”.

Nuestro cuerpo puede producir 10 de los 20 aminoácidos que utiliza para hacer todas sus proteínas, pero los otros 10 tiene que obtenerlos por medio de su dieta, no hay opción. Y siendo tan relevantes, parecería curioso que ningún alimento se anuncie como fuente de algún aminoácido u otro, digamos, cereales ricos en metionina, o galletas con valores elevados de triptofano y valina.

Esto se debe a que los aminoácidos que consumimos no se nos presentan aislados sino, precisamente, en forma de proteínas. Aunque los distintos seres vivos tienen proteínas distintas de las humanas, específicas de cada especie, podemos comerlos y derivar nutrición de ellos precisamente porque nuestro proceso digestivo se ocupa en parte de descomponer las proteínas que consumimos separando los aminoácidos que las forman para poder reutilizarlos. Cada proteína tiene como contraparte a otra proteína, llamada proteasa, que es la enzima que la descompone en sus aminoácidos.

Es como si el ADN de un organismo utilizara los aminoácidos para tejer un tapiz asombrosamente complejo, y luego, durante la digestión, las proteasas pudiera destejer este tapiz, separando sus hilos de distintos colores y grosores para llevarlo a las células donde se tejerán otros tapices distintos reciclando esos hilos.

Y, para llevar el paralelo un poco más allá, nuestro cuerpo también puede producir 10 de los hilos que necesita partiendo de distintas materias primas. Así, nuestras células pueden tomar el ácido glutámico, responsable del sabor llamado “umami”, que es característico de las algas, entre otros alimentos, y modificarlo para crear tres de los aminoácidos no esenciales.

Podemos almacenar algunos de los nutrientes que necesitamos. Pero los aminoácidos excedentes no se guardan como tales, sino que se convierten en glucosa para obtener energía o en ácidos grasos para guardarlos como tejido adiposo. Es por ello que necesitamos proteína en nuestros alimentos diarios para mantener la maquinaria de producción de nuestras propias proteínas en marcha. Cuando no tenemos aminoácidos suficientes en nuestra dieta, el cuerpo puede tomar las proteínas de nuestros músculos y descomponerlas para llevar sus aminoácidos a órganos más esenciales.

Queda, claro, el origen del nombre de estas moléculas fundamentales. Fue el químico suizo Jöns Jakob Berzelius quien en 1838 se convirtió en el primero en describirlas y en quien les puso nombre. Creó el nombre “proteína” tomando la raíz griega “prota”, que significa “de principal importancia”.

Las proteínas y los vegetarianosUno de los problemas que presenta la opción alimenticia de los vegetarianos estrictos, que no comen lácteos ni huevo, es que deben elegir con cuidado sus alimentos. La carne, la leche y el huevo son fuentes de “proteínas completas”, ya que sus proteínas más largas y complejas contienen todos los aminoácidos esenciales. Pero ningún vegetal tiene tales proteínas completas, de modo que el vegetariano consciente debe combinar sus alimentos para no sufrir deficiencias. Un solo aminoácido faltante puede tener efectos negativos en la salud. Ser vegetariano requiere especial atención. |