|

| Leonhard Euler, genial matemático (Pintura D.P. de Emanuel Handmann, vía Wikimedia Commons) |

Un niño que puede desempeñarse igual o mejor que un adulto destacado en algún campo de actividad exigente como ser la música, las matemáticas, el ajedrez o los deportes, es inevitablemente el centro de atención de todos a su alrededor. Muchos quisieran que sus hijos fueran así, e incluso se esfuerzan por impulsar o empujar a los suyos para que alcancen metas poco realistas. Otros simplemente se preguntan qué elementos confluyen para que un niño destaque de modo singular.

Sin embargo, no tenemos una receta para crear niños prodigio. No hay un sistema de educación que favorezca la aparición de la genialidad infantil, y ni siquiera estamos seguros de que la educación pueda realmente impulsar la genialidad. El matemático indostano Srinivasa Ramanujan, nacido en un ambiente nada favorecedor, descubrió las matemáticas formales a los 10 años y dos años después no sólo había dominado la trigonometría, sino que había a empezado a descubrir sus propios teoremas, emprendiendo una carrera que aún hoy es estudiada (sin descifrar por completo) por los matemáticos de todo el mundo.

No sabemos, siquiera, si el concepto “niño prodigio” o “niño genio” significa lo mismo cuando se trata de niños con habilidades distintas. Es posible que un niño de los llamados “calculadores”, capaces de realizar complejísimas operaciones matemáticas, sea totalmente distinto de un precoz ajedrecista, un pintor precoz como Picasso o de genios musicales como el violinista Yehudi Menuhin o el máximo niño prodigio de la música, Wolfgang Amadeus Mozart, el compositor nacido en Salzburgo, Bavaria, hoy Austria, en 1756, que empezó a componer a los 5 años de edad, recorrió Europa de los 6 a los 17 años asombrando al público y se convirtió en uno de los más importantes nombres de la música formal, componiendo prolíficamente hasta su muerte a los 35 años.

Se calcula que un 3% de todos los niños pueden ser considerados altamente dotados o niños prodigio aunque no todos son identificados y estimulados para desarrollar sus habilidades, de modo que la cifra podría ser mucho más alta o más baja.

Es por esto, así como porque la delimitación de qué es o no un niño superdotado es bastante poco clara, hay pocos estudios realizados sobre niños prodigio. En cuanto a edades, distintos grupos y definiciones consideran a los menores de 18, otros a los menores de 15 o 13 años y los más exigentes únicamente a los mejores de 11 años. En cuanto a habilidades, el problema es similar, y no existe un baremo consensuado sobre dónde termina el ser “muy listo o hábil” y comienza la genialidad que, finalmente, es un concepto totalmente subjetivo y humano.

Es por ello que la mayoría de los estudios realizados explorando el funcionamiento del cerebro de los niños prodigio se haya hecho con niños de los llamados “calculadores”, ya que la capacidad de resolver problemas matemáticos es de las que mejor podemos medir y definir con cierta objetividad, a diferencia, por ejemplo, de los talentos artísticos como en las artes plásticas o la música.

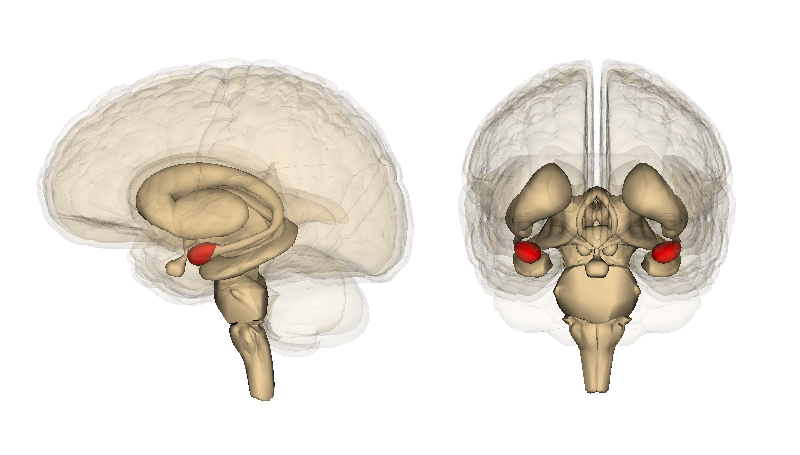

En un estudio de Brian Butterworth, publicado en la revista ‘Nature’ en 2001 se realizaron escaneos de tomografía de emisión de positrones (PET) en niños prodigio matemáticos, y los resultados sugirieron que estos niños utilizaban la memoria de trabajo a largo plazo, una forma en la que se pueden recordar enormes cantidades de datos durante un breve tiempo, y hacían uso intenso de la corteza visual, la zona del cerebro que descodifica las imágenes que vemos y que también empleamos para la imaginación visual. Otros estudios indican que el cerebelo, la zona del cerebro implicada en el control motor, la atención y el idioma, sirve a estos niños para ordenar sus funciones cognitivas y puede influir en su hablidad matemática.

Para muchos niños prodigio, su vocación y talento originales se convierte en su actividad para toda la vida, frecuentemente con enorme éxito. Está Leonhard Euler, matemático suizo que entró en la universidad de Basel a los 13 años y pasó a convertirse en uno de los fundadores de las matemáticas modernas descubriendo, entre otras cosas, el cálculo infinitesimal al mismo tiempo que Newton. El matemático y físico Blas Pascal, que escribió un tratado sobre cuerpos vibrantes a los 9 años y realizaría numerosas aportaciones a la ciencia y la filosofía durante toda su vida. O John Von Neumann, influyente matemático húngaro que en su niñez fue famoso como calculador matemático y polìglota.

Son también comunes los casos de niños prodigio que después de alcanzar logros impresionantes antes de la edad adullta, terminan abandonando todo y no vuelven a realizar las aportaciones por las que fueron conocidos o se retraen como lo hizo de modo espectacular el ajedrecista Bobby Fisher, que ganó ocho campeonatos estadounidenses consecutivos, fue gran maestro a los 15 años y a los 28 se convirtió en campeón mundial, después de lo cual no volvió a competir oficialmente y terminó expatriado en Noruega, con problemas mentales cada vez más evidentes hasta su muerte.

El ejemplo extremo de estos ex-niños prodigio es William James Sidis, dueño de asombrosas habilidades matemáticas y lingüísticas que entró a Harvard a los 11 años. Acosado por sus compañeros y, más tarde, por la prensa sensacionalista, y arrestado por participar en una manifestación de izquierdas (era 1918), acabó aislándose de la sociedad y de las matemáticas trabajando como cobrador de tranvía, anónimo y amargado.

Quien mejor puede definir qué es ser un niño prodigio es, precisamente, alguien que lo ha sido. Justin Clark, campeón de ajedrez a los 8 años y estudiante universitario a los 10: “Lo que pocas personas entienden es que ser un niño prodigio, o ser considerado así, no es inherentemente bueno o malo”. Por más que muchos padres crean que tener un genio es maravilloso, para cualquier niño lo más importante será ser querido y aceptado. Y su peor tragedia es, sin duda, que sus padres o el mundo a su alrededor le pidan más de lo que puede dar, cosa que con frecuencia le exigimos a los genios y a los que no lo son.

El savant, genio en su mundoUn caso especial de los niños prodigio son los savants, que suelen tener una sola capacidad destacada al extremo humano, como puede ser una memoria eidética o fotográfica de un solo aspecto de su vida (como recordar el tiempo que hubo día a día o hacer complejos cálculos matemáticos al instante). Casi la totalidad de los savants tienen problemas de desarrollo, la mitad de ellos asociados al autismo. El ejemplo más conocido de este prodigio es Kim Peek, que fuera la base para el personaje que interpretó Dustin Hoffman en la película “Rain Man”. |