|

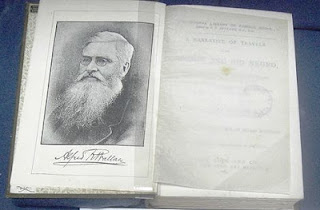

| Mary Wollstonecraft Shelley (Retrato D.P. de Reginald Easton, via Wikimedia Commons) |

Este relato tiene un gran atractivo literario, incluido el científico distraído que por error realiza un descubrimiento relevante, pero por desgracia es un simple mito. En realidad, el trabajo de Galvani había comenzado mucho antes, observando cómo la electricidad afectaba a los músculos de las ranas antes de publicar sus conclusiones en las actas del Instituto de Ciencias de Bolonia en 1791 con el título Comentario sobre la fuerza de la electricidad en el movimiento muscular.

La misteriosa electricidad había sido estudiada por primera vez con detenimiento en 1600, por el inglés William Gilbert, entre otras cosas médico de Isabel I, quien descubrió que nuestro planeta es magnético y acuñó el término “electricus” denotar lo que hoy llamamos “electricidad estática”, la capacidad del ámbar de atraer objetos ligeros después de frotarlo.

Pero fueron estudiosos como Benjamín Franklin (quien demostró que los relámpagos son electricidad) o Alessandro Volta los que dispararon el interés por la electricidad. Volta, colega, amigo y vecino de Galvani, consideraba que las convulsiones de las ranas se debían sólo a que el tejido servía como conductor, mientras que Galvani consideraba que los seres vivos tenían y generaban electricidad.

Para demostrar que su amigo se equivocaba, por cierto, Volta creó su primera pila, la madre de todas las baterías, con objeto de tener una corriente eléctrica continua para sus experimentos

Y entonces apareció Mary Shelley, que tenía todavía de apellido Wollstonecraft en 1816, cuando el poeta Percy Bysse Shelley con el que había huido a Ginebra (el escritor estaba casado con otra) les propuso a ella, al también poeta Lord Byron y al médico John Polidori escribir un cuento de terror.

Los miembros del grupo ya habían comentado los descubrimientos sobre electricidad y Mary, de sólo 18 años, leía sobre los descubrimientos del italiano. Tuvo entonces una pesadilla donde vio a un estudiante de “artes impías” dando vida a un ser utilizando una máquina. El resultado fue la novela Frankenstein o el moderno Prometeo, que publicaría finalmente en 1819, ya en Inglaterra y casada con el poeta. Por ese libro, para la mayoría de la gente el apellido “Shelley” evoca al monstruo y a su atormentado creador, antes que a los versos de Ozymandias o la Oda al viento del este.

El debate entre Galvani y Volta se habría resuelto en 1794 con la publicación de un libro de Galvani que incluía un experimento en el cual los músculos de una rana se contraían al ser tocados no por una placa metálica con una diferencia de potencial, sino con una fibra nerviosa de otra rana. Pero por alguna causa, la publicación se hizo de manera anónima.

Hubo de llegar el naturalista alemán Alexander von Humboldt a realizar una serie de experimentos que demostraron que el tejido animal era capaz por sí mismo de generar un potencial eléctrico, lo cual por cierto quedaba también demostrado con su trabajo sobre anguilas eléctricas, cuya capacidad de causar violentas reacciones en sus víctimas era bien conocida, pero no se había explicado hasta entonces.

Demostrado pues que las fibras nerviosas eran conductoras y generadoras de electricidad, se sucedieron los descubrimientos. Supimos que el sistema nervioso está formado por células cuyas prolongaciones forman las fibras nerviosas o que existe un aislante eléctrico natural en estas fibras, la mielina. Se midió la la velocidad de los impulsos nerviosos y se fue describiendo cómo el sistema nervioso transmite órdenes y recibe información electroquímicamente de célula en célula.

Las derivaciones médicas vinieron pronto. Además de los charlatanes que vendían por igual agua electrizada para curarlo todo o slips eléctricos para la impotencia masculina, la detección de los potenciales eléctricos se convirtió en procedimientos de diagnóstico como la electrocardiografía y la electroencefalografía, entre otros, mientras que las descargas eléctricas de intensidad variable se empezaron a utilizar para la estimulación muscular en rehabilitación, para el manejo del dolor, apoyando la cicatrización pues mejoran la microcirculación y la síntesis de proteínas en zonas lesionadas, y aplicadas directamente en el cerebro mediante electrodos para afecciones tan distintas como la enfermedad de Parkinson y la depresión grave.

Pero el más espectacular uso de la electricidad en medicina sigue siendo evocador de las ranas de Galvani y del momento en que Frankenstein le da vida a su criatura: es el desfibrilador. En 1899, los investigadores Jean-Louis Prévost y Frederic Batelli descubrieron que una descarga eléctrica podía provocar la fibrilación (el latido irregular del corazón, que lleva a un fallo catastrófico) mientras que una descarga aún mayor podía invertir el proceso, regularizando el ritmo cardíaco.

Desde 1947, cuando el médico estadounidense Claude Beck lo usó por primera vez para salvar a un paciente de 14 años, el desfibrilador se ha desarrollado y ha salvado una cantidad incalculable de vidas.

Pero el cine y la televisión suelen mostrar el uso de desfibriladores para “poner en marcha” un corazón que se ha detenido (la temida línea recta del electrocardiógrafo con su siniestro pitido). Pero esto no ocurre así. La descarga eléctrica no puede arrancar un corazón detenido. Al contrario, detiene momentáneamente el corazón, bloqueado por impulsos desordenados, de modo que su marcapasos natural, un grupo de células nerviosas llamado “nodo sinoatrial”, pueda entrar en acción. Es una forma de restaurar el funcionamiento corazón. Pero cuando el corazón se ha detenido y el nodo sinoatrial no está enviando impulsos, lo que se utiliza son distintos compuestos químicos para ponerlo nuevamente en marcha… lo cual es bastante menos cinematográfico por útil que resulte.

El temido electroshockLa terapia electroconvulsiva es materia de muchas historias de terror por la forma en que se utilizó en las décadas de 1940 y 1950. Sin embargo, hoy se aplica sólo con el consentimiento del paciente y bajo anestesia. Si bien no es una panacea, no es tampoco un procedimiento que afecte al paciente y sí es una herramienta útil en casos de depresión grave y otros problemas. |