|

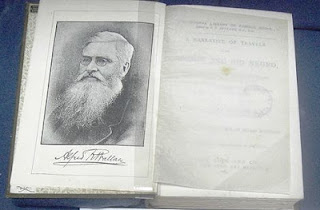

| Wernher Von Braun en su despacho de director de la NASA en 1964. (foto D.P. de la NASA, vía Wikimedia Commons) |

Ese histórico momento marcó también un hito político. Terminaba la carrera espacial, iniciada en 1957 con el satélite Sputnik I de la Unión Soviética. Las dos superpotencias que habían emergido como hegemónicas después de la Segunda Guerra Mundial habían vivido una competencia vertiginosa en pos de distintas hazañas espaciales para evitar que su adversario los superara tecnológicamente. Cada logro se presentaba además como prueba de la superioridad del comunismo o del capitalismo, según el caso.

Desde el despacho de director de la NASA, Werhner von Braun veía coronado un sueño acariciado desde su adolescencia: llevar al ser humano más allá de nuestro planeta, primero a la Luna como preludio del soñado viaje a Marte. Y lo había hecho no sólo como administrador de la agencia espacial estadounidense, sino como ingeniero y visionario responsable del desarrollo del los cohetes de la NASA, llegando al Saturno V, el más potente fabricado incluso hasta la actualidad, para llevar al hombre hasta la Luna.

Pero en el proceso de conseguir esta verdadera hazaña tecnológica y humana, Wernher von Braun había pagado un alto precio humano. Un precio que hasta hoy no conocemos con precisión.

La ilusión del vuelo espacial

Werhner Magnus Maximilian von Braun nació el 23 de marzo de 1912 como heredero de un barón prusiano en Wirsitz, Alemania. Su pasión por el espacio se inició en su niñez y adolescencia, con el telescopio que le dio su madre y mediante la la lectura de los libros de ciencia ficción de Jules Verne y H.G. Wells y por las sólidas especulaciones científicas del físico Hermann Oberth en su libro “Por cohete hacia el espacio interplanetario”. Muy pronto se hizo parte de la sociedad alemana para los viajes interplanetarios fundada por Oberth en 1927, una de varias organizaciones similares en los Estados Unidos, Gran Bretaña o Rusia, que experimentaban con lanzamientos de pequeños cohetes.

Buscando trabajar con cohetes más grandes y presupuestos acordes al sueño, empezó a trabajar en 1932 con el gobierno alemán en el desarrollo de misiles balísticos, dos años antes de obtener su doctorado en física, y siguió trabajando para el ejército después de que Hitler ascendiera al poder en 1933, y en 1934 consiguió lanzar dos cohetes que ascendieron verticalmente más de 2 y 3 kilómetros.

En 1937, trabajando ya en el centro militar de cohetes de Peenemünde, solicitó su ingreso en el Partido Nazi, aunque afirmó que se le invitó a incorporarse en 1939 y que se vio obligado a hacerlo para continuar con su trabajo, aunque no hay evidencia de que haya realizado ninguna actividad política. Ciertamente, no habría podido continuar trabajando en cohetes pues el régimen nazi prohibió toda experimentación civil. Von Braun continuó trabajando los primeros años de la Segunda Guerra Mundial en el desarrollo de combustibles líquidos para misiles capaces de llevar cargas explosivas.

En 1942, Hitler no sólo había perdido estrepitosamente la Batalla de Inglaterra de 1940, sino que la aviación británica había comenzado a bombardear ciudades alemanas, de modo que ordenó la creación de un arma de venganza dirigida principalmente contra Gran Bretaña. Esta arma, el cohete V2, diseñado por Von Braun, estuvo lista en septiembre de 1944. El ejército alemán lanzó más de 3.000 de estos cohetes, producidos en fábricas con trabajo esclavo de los campos de concentración, contra blancos en Bélgica, Francia, Gran Bretaña y Holanda, dejando un saldo de al menos 5.000 muertos y muchos más heridos. Siempre quedaron dudas sobre cuánto sabía Von Braun de la mano de obra que producía sus cohetes o cuánto podría haber hecho por ellos.

Entretanto, Von Braun había estado brevemente preso en marzo de 1944 acusado de tener simpatías comunistas y una actitud “derrotista” ante el esfuerzo bélico alemán, pero fue liberado por su importancia para el programa de las V2.

Vencida Alemania, Von Braun orquestó un plan para rendirse con su equipo al ejército estadounidense antes de ser capturados por los soviéticos, y pronto se vio trabajando con el ejército antes enemigo, lanzando en el desierto de Nuevo México cohetes V2 capturados por el ejército y desarrollando nuevas armas como el misil Júpiter.

El lanzamiento del Sputnik I en 1957 por parte de los soviéticos (con el apoyo de otros científicos alemanes como Helmut Gröttrup) hizo que el gobierno de Estados Unidos acelerara su esfuerzo hacia los viajes espaciales, lanzando en 1958 el Explorer I, satélite científico que preparaba Von Braun desde 1954 y creando la NASA, de la que el científico alemán se convirtió en director en 1960.

Desde ese momento, Von Braun sería no sólo una pieza clave en la ciencia y tecnología del esfuerzo espacial estadounidense, sino uno de sus grandes defensores públicos. Durante los siguientes diez años se convertiría en la imagen misma de la carrera espacial del lado estadounidense y conseguiría estar siempre sólo un paso atrás de la Unión Soviética, que acumuló una serie impresionante de primeros logros (primer ser vivo en órbita, primer humano en órbita, primeras naves en la Luna y en Venus) pero fue superada en el objetivo final, la Luna, en 1969.

Ese objetivo, sin embargo, enfrió el entusiasmo público por los viajes espaciales, y Von Braun vio cómo el programa Apolo sufría recortes presupuestales que hacían imposible su siguiente sueño: llevar a un hombre a Marte. En 1972 decidió dejar la NASA para pasar al sector privado en la empresa aeronáutica Fairchild Industries, y murió de cáncer de páncreas en 1977, con apenas 65 años de edad.

La búsqueda por el “verdadero” Von Braun sigue. Sin embargo, los matices de su relación con los nazis y la medida en que su sueño de viajes espaciales pudo o no cegarlo a una realidad atroz tendrán siempre que ser parte de la historia del hombre que llevó a la humanidad a la Luna.

La operación PaperclipPaperclip, literalmente "sujetapapeles", fue el programa de la Oficina de Servicios Estratégicos de las fuerzas armadas estadounidenses para reclutar científicos de la Alemania nazi para Estados Unidos, evitando que fueran reclutados por la Unión Soviética. El presidente Harry S. Truman ordenó excluir a miembros del Partido Nazi, o gente que hubiera participado activamente en él o apoyara activamente el militarismo nazi. Para eludir esta orden, las propias agencias de inteligencia crearon papeles y antecedentes falsos para blanquear el pasado de muchos científicos, entre ellos Wernher von Braun. |