|

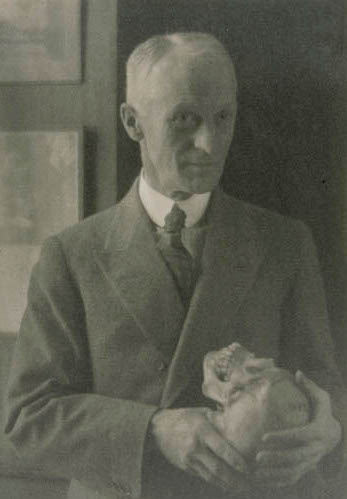

| Nicholas Appert, inventor de las conservas (imagen D.P. via Wikimedia Commons) |

El problema de la conservación de los alimentos ha sido preocupación principal del ser humano durante toda su existencia, porque... ¿de qué sirve acumular comida, ser previsores y llenar nuestras despensas si la comida se echa a perder, se pudre, se enmohece, se arrancia, se endurece, pierde color y sabor y finalmente resulta imposible de comer? Una buena cosecha o una cuantiosa cacería, no son de abundancia a largo plazo si no se conservan.

La conservación de los alimentos tuvo una importancia capital para la supervivencia y el desarrollo de nuestra especie, facilitando el paso del nomadismo al sedentarismo, el comercio de alimentos a gran distancia, que más gente tuviera acceso a mejores alimentos, reduciendo las enfermedades transmitidas por los alimentos y, por supuesto, permitió la supervivencia al ofrecer suministros para enfrentar los inviernos y los tiempos de mala cacería o bajos rendimientos agrícolas.

La lucha por la conservación de los alimentos se da en dos frentes. El primero busca combatir, inhibir o dejar fuera a las bacterias que producen la descomposición. El segundo busca mantener o aumentar incluso las características que percibimos de los alimentos (su color, sabor, aspecto, aroma, etc., que es lo que los expertos conocen como sus “propiedades organolépticas”.

En las sociedades prehistóricas, el método más común para preservar los alimentos era cocinarlos de diversas formas. Este proceso mata a los microorganismos responsables de la descomposición y los mantiene a raya más tiempo. Además, nuestros ancestros crearon procedimientos para conservar la carne que seguimos usando, como el ahumado, que es antimicrobiano y antioxidante; el curado con sal, que impide la proliferación de bacterias al deshidratarlas cuando entran en contacto con la sal, y el secado mediante el sol, que al eliminar la humedad del alimento dificulta igualmente la proliferación bacteriana.

Otro procedimiento tradicional para conservar los alimentos es la fermentación, como la del vino, los quesos o la cerveza, en la que se somete al alimento a la acción de unos microorganismos concretos (levaduras y mohos) que ocupan el lugar que de otro modo tendrían organismos que descomponen los alimentos. Precisamente este medio ambiente tóxico es el que crean los hongos del genus o grupo de especies Penicillium, al producir la sustancia que llamamos penicilina, un potente antibiótico, y que son los responsables de la preservación de los quesos azules, el camembert, el brie y otros.

Las conservas en salmuera, vinagre, alcohol o aceites vegetales, que son líquidos comestibles, funcionan inhibiendo el crecimiento de las bacterias o matándolas, mientras que la conserva de productos cocinados en líquidos con alto contenido de azúcar (como las mermeladas) evita las bacterias porque tiene una presión osmótica tan elevada que no permite que vivan casi microbios en su interior.

Estos sistemas fueron los básicos de la conservación de alimentos hasta el siglo XVIII, cuando la tecnología empezó a desarrollar nuevas opciones. En 1810, el confitero francés Nicholas Appert dio a conocer su invención de la conservación hermética de los alimentos, que colocaba en frascos de vidrio que sellaba con corcho y lacre, y posteriormente colocaba en agua hirviendo. Cambiando los frascos de vidrio por latas metálicas se obtiene el moderno sistema de enlatado.

Enfriar o congelar los alimentos fue un método marginal usado en zonas donde se podía recoger hielo o nieve, pero no se pudo utilizar ampliamente sino hasta la creación de la refrigeración artificial en 1756, que llevó a la producción artificial de hielo y, finalmente, a las neveras mecánicas domésticas, que empezaron a llegar a los hogares en 1911.

A este arsenal de métodos de conservación se han añadido otros en los últimos años, que van desde sustancias con propiedades conservantes hasta sistemas como la irradiación de los alimentos con rayos X, gamma o electrones de gran energía; la aplicación de pulsos de un potentísimo campo eléctrico, o el empacado al vacío o con una atmósfera baja en oxígeno.

Al eliminar el oxígeno de los alimentos se presenta el riesgo del botulismo, es decir, el envenenamiento frecuentemente mortal con la toxina producida por la bacteria Clostridium botulinum, que es anaeróbica, lo que significa que vive y se reproduce sin necesidad de oxígeno. Para evitar también la proliferación de esta bacteria se utilizan otras sustancias, como las sales llamadas nitritos.

Entre las sustancias que inhiben la actividad de bacterias y hongos se encuentra el benzoato de sodio, una sal que se presenta de modo natural en algunos alimentos, y que se añade a otros, especialmente si tienen un pH ácido. La misma función la realizan sustancias como el sorbato de potasio. Los propionatos, por su parte, inhiben el crecimiento de moho en los alimentos horneados, destacadamente el pan y las galletas.

Algunas personas y grupos tienen la preocupación de que las sustancias conservantes que se utilizan en la actualidad tengan peligros desconocidos para la salud. Los estudios que se llevan a cabo con estas sustancias tienen por objeto determinar si existe este riesgo y en qué medida, teniendo presente que nada de lo que consumimos, nada de lo que hay en el universo, está totalmente exento de riesgo, y todo depende de cantidades, dosis, y la delicada relación entre el beneficio y los peligros.

Finalmente, los procesos tradicionales de conservación tampoco están exentos de peligros. Consumidos en exceso, los productos ahumados, curados o salados aumentan el riesgo de cáncer estomacal, además de que el exceso de sal es un riesgo para las enfermedades cardiacas, y ciertamente las personas con diabetes no pueden consumir productos conservados con azúcar, jarabes o miel.

Si bien debemos estar alerta a los posibles peligros, no podemos olvidar que los sistemas de conservación, tanto los actuales como los que podamos desarrollar, serán esenciales no sólo en la lucha contra el hambre, sino en una nutrición de calidad para todos los seres humanos. Nuestra especie no habría prosperado si no hubiera aprendido a preservar sus alimentos, lo cual también jugará un papel en su éxito futuro, su desarrollo o su extinción.

Una víctima del fríoEn 1626, uno de los padres del método científico, Sir Francis Bacon, se propuso experimentar la posibilidad de conservar un ave rellenándola de nieve, mismo que, escribió Bacon “triunfó excelentemente bien”. Sin embargo, en el proceso, contrajo una pulmonía que unas semanas después lo llevaría a la muerte, como mártir de la ciencia... y de la conservación de los alimentos. |

.jpg/320px-Star-forming_region_S106_(captured_by_the_Hubble_Space_Telescope).jpg)