|

| Fotografía ©Mauricio-José Schwarz |

Ciertas cosas nos parecen bellas y otras no. Dado lo intensa que resulta nuestra reacción ante la belleza (y ante su opuesto, lo feo), el tema ha sido apasionadamente estudiado por la filosofía. Y también por la ciencia. Así, Pitágoras impulsó el desarrollo de la música al descubrir que los intervalos musicales no son sino subdivisiones matemáticas de las notas.

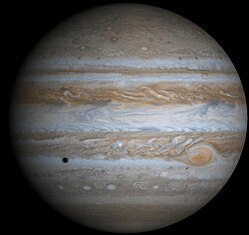

Grecia también nos dio el descubrimiento de la proporción áurea, también tema de Pitágoras y de Euclides, y que es cuando dos cantidades tienen un cociente de 1.618, la constante denotada con la letra griega “fi”. Esta proporción resulta especialmente atractiva a la vista, y los artistas la han usado en sus obras, desde los templos griegos, como el Partenón, que al parecer está construido sobre una serie de rectángulos dorados, hasta una gran parte de la pintura, arquitectura y escultura renacentista.

La proporción áurea, como se descubrió después, está también presente en la naturaleza, en elementos tan diversos como la concha del cefalópodo arcaico llamado nautilus o las espirales que forman las semillas de los girasoles (o pipas).

Pero nada de esto nos dice qué es lo bello y, menos aún, por qué nos lo parece.

Tuvo que llegar la psicología del siglo XX para empezar a analizar experimentalmente nuestras percepciones y tendencias y abrir el camino a la explicación científica de por qué algo nos parece bello.

La ciencia del arte

Uno de los más importantes neurocientíficos, Vilayanur S. Ramachandran de la Universidad de California, junto con el filósofo William Hirstein, se propuso disparar el estudio neurológico del arte con un artículo publicado en 1999 en el que proponía entender el arte a través, tentativamente, de ocho “leyes de la experiencia artística”, basado en sus estudios del cerebro y, especialmente, de alteraciones neurológicas como las que padecen los savants, que suelen tener una gran facilidad para la creación artística, tanto musical como gráfica.

Para Ramachandran y Hirstein, en la percepción del arte influye ante todo el “efecto de desplazamiento del pico”, que es fundamentalmente nuestra tendencia a la exageración. Si se entrena a un animal para diferenciar un cuadrado y un rectángulo de proporción 2:3, premiándolo por responder ante el rectángulo, la respuesta será aún más intensa ante un rectángulo más alargado, digamos de proporción 4:1. Es lo que hace un caricaturista al destacar los rasgos distintivos y eliminar o reducir los demás, provocando en nosotros el reconocimiento. O lo que hace el artista al destacar unos elementos placenteros y obviar otros.

Entre los aspectos propuestos por Ramachandran y Hirstein, uno de los más apasionantes es el de la metáfora. Cuando se hace una comparación metafórica como “Julieta es el sol”, tenemos que entender (y nos satisface hacerlo) que Julieta es tibia y protectora, no que sea amarilla y llameante. El proceso de comprensión de la analogía es en sí un misterio, pero más aún lo es el por qué, sobre todo desde un punto de vista evolutivo, nos resulta gratificante hacerlo.

Según estos estudiosos, el arte incluye aspectos como el aislamiento de un elemento de entre muchos al cual prestarle atención, la agrupación de elementos y algo que la psicología cognitiva tiene muy en cuenta en el estudio de la belleza humana: la simetría.

El rostro humano

Los estudios sobre la belleza humana también demuestran que la simetría es uno de los requisitos esenciales de la belleza, y esto ocurre en todas las culturas humanas y a todas las edades. Los bebés prefieren observar objetos o rostros simétricos en lugar de los que no lo son.

Otro de los descubrimientos asombrosos sobre el rostro humano es que un “promedio” informático de una gran cantidad de fotografías tiende a ser apreciado como más hermoso que los rostros que le dieron origen. Al menos en cierta medida, consideramos bello lo que tiende a la media.

Las características “infantiles” de las crías de los animales con cuidados paternos (grandes ojos, nariz y boca pequeñas, gran cabeza), disparan en nosotros reacciones de ternura y cuidado. Los estudios han determinado que estos rasgos son también un componente de la belleza, especialmente la femenina. El rostro de la mujer adulta retiene ciertos rasgos infantiles que el hombre pierde con la madurez sexual. Aunque cierta feminidad en el rostro del hombre tambíen es apreciada como un componente de belleza por las mujeres.

A fines de los años 90, los psicólogos Víctor Johnston y Juan Oliver-Rodríguez consiguieron observar al cerebro humano reaccionando ante la belleza, al analizar electroencefalogramas de sujetos que habían visto una serie de rostros. Unas ondas, llamadas “potenciales relacionados con acontecimientos” aumentaban cuando los sujetos observaban rostros que consideraban hermosos.

Aunque no conocemos aún el mecanismo paso a paso, sabemos que la sensación placentera que nos provoca la contemplación de la belleza surge de la activación del sistema límbico, una serie de estructuras en lo más profundo de nuestro cerebro donde residen las sensaciones de placer y de anticipación ante la posibilidad del placer.

Todos los elementos que contribuyen a que una persona sea considerada hermosa o no (y dejamos fuera muchos, como el de la estatura) son independientes de la cultura. Aunque cada cultura realizan sus peculiares variaciones sobre los temas básicos, ninguna considera especialmente bellos la asimetría, la piel defectuosa, los extremos apartados de la media o los rostros femeninos duros, angulosos y sin rasgos infantiles.

Queda por averiguar, por supuesto, qué valor evolutivo tiene nuestra apreciación de la belleza, cómo surgió en nuestra historia, por qué y, sobre todo, cómo funciona paso a paso.

Los biólogos evolutivos proponen que quizá la belleza comunica a los demás la calidad y deseabilidad de su portador. Así parece funcionar en todas las especies que tienen rasgos decorativos para atraer a sus potenciales parejas mostrando su salud, fuerza y capacidades, aunque esto no tenga, en nuestra sociedad tecnológica, el valor que pudo tener hace cien o doscientos mil años.

Esclavos de la bellezaLos estudios demuestran que las personas guapas tienen mejores oportunidades en nuestra sociedad, en la vida profesional y personal. Si queremos allanar el campo de juego debemos entender el mecanismo de este hecho, que hoy parece que no es, como se quiso creer en las últimas décadas, un asunto meramente cultural. Porque finalmente, como dice Ulrich Renz, autor de La ciencia de la belleza, si existiera una píldora para hacernos más bellos... ¿quién no la tomaría? |